苏州市干将路303号创意产业园

0512-3565 6563

Jackjones@kuaidata.com

联系客服

数据中心托管服务/管理式网络

服务:

400 651 8888

微软云服务:

400 089 2448

markjune@kuaidata.com

内容分布式网络服务:

400 811 0278

云集成与合作:

cloud@kuaidata.com

智算中心建设为何要选在西部集群?|算力产业十问

2023-09-11

2023年,生成式人工智能的崭露头角,预示着全球人工智能产业即将迎来一个爆发式增长的新纪元。以ChatGPT为典型代表的AI大模型不仅在全球范围内持续激活市场需求,更为关键的是,它们对庞大智能算力的不断追求,凸显了智算中心在全球AI产业链中的核心与不可替代性。我国的西部集群地区,得益于其丰富的自然资源和有力的政策支持,未来很可能会成为我国甚至全球智算中心新的战略高地。

AI大模型爆发,智能算力成必然选择

在新一轮生成式AI热潮中,众多科技巨头、互联网大厂、上市公司纷纷上线各类AI大模型。自2023年3月以来,科技巨头如百度、华为、阿里巴巴、商汤科技、科大讯飞和昆仑万维等纷纷推出了各自的大模型产品,进一步加速了AI大模型的市场渗透。据专业媒体不完全统计,截止2023年7月,中国已发布的大模型超过100个,主要分布在北京、上海、广东三地,其中北京地区的大模型多达54个。不仅如此,近几个月以来,各行业垂类大模型也在持续增长,教育、医疗等行业大模型数量增长尤其迅速。

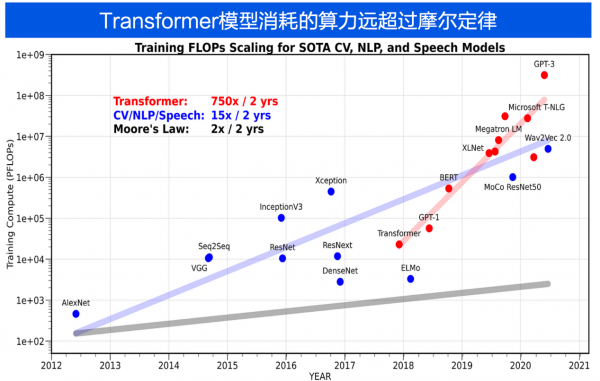

AI大模型对算力的消耗值

AI大模型不仅放大了对算力的数量需求,而且在质量和特性上也提出了全新的挑战,与传统通用算力(基础算力)有明显区别。首先,计算复杂性方面,AI大模型涉及大量矩阵运算和并行处理,需要高度优化的算力,而通用算力更侧重于一般数据处理和业务逻辑。其次,硬件架构上,智能算力依赖于专为AI设计的加速器如GPU和TPU等,以实现高效训练和推理,而通用算力通常基于CPU架构,处理AI任务时效率较低。最后,从能效比(FLOPS/Watt)考虑,智能算力更注重能效优化,因AI大模型需要大量电能。相比之下,通用硬件在能效方面可能落后。总体而言,AI大模型不仅增加了算力的数量需求,还在质量上提出了新挑战。也因此,智算中心正在成为大模型厂商未来AI业务的必然选择。

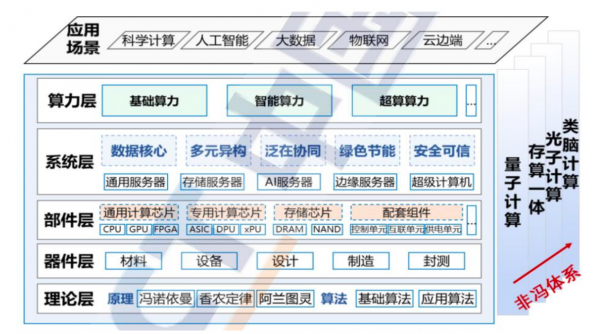

先进计算技术产业(基础算力、智能算力超算算力)体系框架

能量敏感型业务激发智算中心建设需求

据中国IDC圈不完全统计,2023年7月到9月初,我国规划在建及建成智算中心项目就超过36个,预计总投资规模超过460亿。仅从已公布算力规模的16个项目来看,总规划算力就超过了15000P。

显然,进入2023年下半年,我国智算中心建设进入了明显的加速期。根源在于生成式AI爆发背景下,各大厂商AI大模型需求的刺激。AI大模型因其庞大的参数量和复杂的计算过程,对计算力有极高的需求,这种需求直接拉动了智算中心的建设和扩张,但同时也带来了对电力的更大消耗。AI大模型与智算中心之间形成了一种密切且复杂的相互依赖关系,它们共同推动了各自以及整个数据中心行业的快速发展和技术革新。不同于传统的数据中心提供的时延敏感型业务(但通用算力并不都是时延敏感),智算中心其实是典型的能量敏感型业务,简单说就是用户对电费更加敏感。

能量敏感型业务是一种对能源消耗,尤其是电力成本,具有极高敏感性的业务模式。在数据中心领域,智算中心由于其特殊的运营需求和技术特性,成为了能量敏感型业务的代表。生成式AI模型,如GPT-4、百度文心一言等,通常需要大量的并行计算资源。这些模型通常由数十亿甚至数百亿的参数组成,需要在多个GPU或TPU上进行大规模并行计算。

智算中心未来要建在西部集群

仅以一个拥有1000台AI高密度机柜的智算中心为例,单机柜功率按30KW计算:

- 单个机柜每小时耗电:30KWh

- 1000个机柜每小时耗电:30KWh * 1000 = 30,000KWh

- 每天耗电:30,000KW * 24 = 720,000MWh

- 每月耗电:720,000KWh * 30 = 21,600,000KWh

21,600,000KWh,也即每月需要消耗2160万度电

对比智算中心建设在东西部的电费差异,每度电0.1元的差异将带来电费成本的巨大变化,每月仅电费成本差异将达到数百万元,这还不包括西部地区可能提供的其他优惠政策和税收减免。因此,从成本效益和可持续性角度考虑,建设智算中心,尤其是面向未来建立大规模的智能算力集群,西部城市无疑是更为合适的选择。而地处西部的中卫市因其丰富的可再生能源资源和得天独厚的政策优势,有望成为智算中心建设的理想之地。